A finales del pasado mes de marzo apareció en las redes una carta abierta, promovida por el Future of Life Institute, pidiendo una moratoria de seis meses en los «grandes experimentos con IA», especialmente en «el entrenamiento de sistemas más potentes que GPT-4». El Instituto desde el que se toma esta iniciativa es defensor de ideas cercanas a planteamientos transhumanistas y a la filosofía conocida como «largoplacismo», y eso explica que la carta contenga algunas afirmaciones discutibles y que no todos los firmantes aceptarían, como alguno ya ha explicado. Por ejemplo, cuando se pregunta: «¿Deberíamos desarrollar mentes no humanas que, con el tiempo, pudieran superarnos en número, en inteligencia, volvernos obsoletos y reemplazarnos? ¿Debemos arriesgarnos a perder el control de nuestra civilización?». Esta posibilidad es lo que los transhumanistas llaman “la Singularidad” y están convencidos de que va a ocurrir más pronto que tarde, pero es una posibilidad recibida con escepticismo por muchos especialistas en IA, entre ellos firmantes de la carta como Gary Marcus o Ramón López de Mántaras.

La carta ha recibido duras críticas desde el primer momento. Hay quien piensa que es pura propaganda o, por el contrario, que intenta infundir el miedo sobre una tecnología que, como todas, por mucho que despierte recelos en un principio, traerá profundos beneficios para la humanidad. Veleidades neoluditas, al fin y al cabo. Así, pocos días después de la publicación, el 2 de abril Yann LeCun, uno de los más lúcidos y prudentes especialistas en IA, científico jefe en Meta y reciente premio Princesa de Asturias, escribió en su muro de Facebook: «No es una inocentada. Al amplificar la inteligencia humana, la IA puede causar un nuevo Renacimiento, tal vez una nueva fase de la Ilustración. Pero las profecías de una destrucción por parte de la IA están generando también una nueva forma de oscurantismo medieval. No es una inocentada».

No hace falta estar de acuerdo con el contenido de la carta al cien por cien, y mucho menos simpatizar con los objetivos del Future of Life Institute, para considerar que ha dado voz a una gran preocupación generada en gran medida por los avances extraordinariamente rápidos y sin control que vienen dándose en los últimos años en el campo de la IA. Los peligros reales no son los de escenarios distópicos al estilo Terminator. No hay por qué aceptar que vamos a tener pronto máquinas superinteligentes que van a tomar el control de todo y, por maldad o desidia, van a acabar con nuestra especie. Ni siquiera es necesario creer que los sistemas de IA que tenemos tienen auténtica inteligencia. Sean inteligentes o no, están teniendo ya consecuencias preocupantes sobre las que conviene pensar.

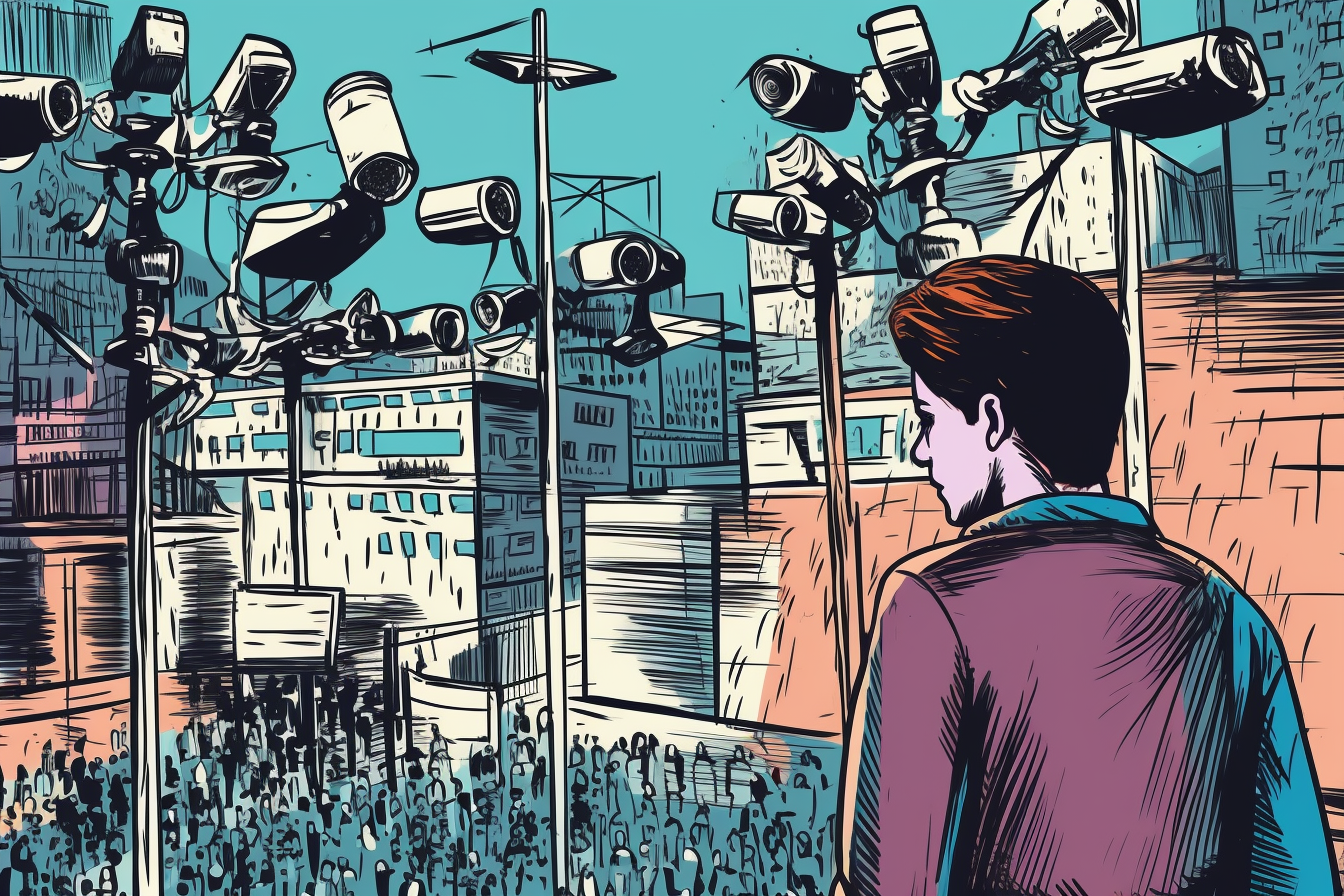

Se están viendo ejemplos muy inquietantes de cómo, con su ayuda, se pueden crear con gran facilidad y realismo noticias falsas, con imágenes y vídeos incluidos, capaces de engañar a los más avezados. La proliferación de este tipo de noticias podría dar lugar a una crisis de credibilidad en los medios de información y contribuir de forma notable a la polarización e inestabilidad política, debilitando con ello las bases de la convivencia democrática.

Un ejemplo particularmente significativo es el de los sistemas de reconocimiento facial. En China y en Rusia se utilizan para controlar a los disidentes políticos. La compañía china Haiwei proporciona tecnología de vigilancia inteligente a más de cincuenta países. Como señala Stephanie Hare en su libro Technology is not neutral, «en Rusia las autoridades han estado utilizando la red de cámaras de reconocimiento facial de Moscú para identificar y detener a las personas que asisten a las protestas en apoyo de Alexey Navalny. […] Algunas de las personas que han sido detenidas son periodistas que asistían a las protestas a título profesional, y las autoridades también están investigando a abogados y médicos que brindaron asistencia profesional a activistas de la oposición».

Aunque el peligro para el ciudadano es obviamente mucho mayor en sociedades gobernadas por regímenes autoritarios, eso no significa que las democracias avanzadas estén libres de peligros. En el mismo libro se nos habla, por ejemplo, de la situación en Gran Bretaña, donde centros comerciales, ayuntamientos e incluso la policía metropolitana hacen uso de estos sistemas.

En los órganos de gobierno de la Unión Europea hay una convicción cada vez más generalizada de que el uso indiscriminado de sistemas de reconocimiento facial en lugares públicos, incluso para fines policiales, debe ser prohibido. La propuesta de reglamento del Parlamento Europeo y del Consejo sobre la armonización de la inteligencia artificial, publicada en 2021, ya establecía que los datos biométricos no se pueden obtener sin el consentimiento de las personas, que estas deben ser informadas siempre al respecto. Y más recientemente, el documento titulado «Directrices sobre el uso de la tecnología de reconocimiento facial en el ámbito de la aplicación de la ley», publicado en 2022, establece en sus conclusiones que «la identificación biométrica remota de personas en espacios de acceso público plantea un alto riesgo de intrusión en la vida privada de las personas y no tiene un lugar en una sociedad democrática pues por su naturaleza implica vigilancia masiva». El documento recomienda su prohibición total.

A todo esto, añadamos la pérdida de privacidad por el uso comercial e incluso político (recuérdese el escándalo de Facebook y Cambridge Analytica) que las compañías tecnológicas hacen de nuestros datos. Estas compañías están acumulando tanto poder que condicionan fuertemente las decisiones de muchos países y pueden esquivar el pago de impuestos, aumentado con ello sus beneficios. Añadamos también el uso militar de la IA en las armas autónomas. O el peso que las decisiones tomadas por sistemas de IA tienen en la vida de cada vez más personas, por ejemplo, a la hora de ser seleccionadas para un trabajo o de concederles una hipoteca. Se han constatado graves sesgos de género y de raza en estos sistemas, lo que ha conducido a situaciones de injusticia e incluso han destrozado algunas vidas, como explicaba muy bien Cathy O’Neil en su libro «Armas de destrucción matemática». Añadamos los usos fraudulentos de la IA en finanzas o para la comisión de delitos comunes, etc.

Es sumamente improbable que se cumpla la moratoria que pide la carta abierta. Los intereses en contra son muy poderosos. Difícilmente las compañías norteamericanas van a parar la investigación en IA cuando su máximo competidor, China, no lo va a hacer. Supongo que esto lo saben bien la mayor parte de los firmantes de la carta. Pero lo importante es haber llamado la atención del público general y de los políticos (habitualmente muy mal informados) acerca de los riesgos importantes a los que nos enfrentamos, los cuales reclaman una mayor consideración de la tarea reguladora y de gobernanza de la IA. Al campo hay que ponerle puertas (se puede). Y esto no implica renunciar en nada a los efectos beneficiosos de la IA.

Quizás parezca un artículo extremadamente alarmista pero creo que es lo suficientemente importante para que los gobernantes ya vayan buscando buenos expertos en el tema de la IA que permitan una asesoría conveniente cara a un futuro próximo

Lo de preguntar a la ciudadanía que opina ni se les pasa por la cabeza. Un puñado de compañías multimillonarias están decidiendo los destinos de la humanidad y el pueblo a asistir como espectador sin derecho a voz, ni voto una vez más.

Toma democracia de la buena.

el bostezo que me ha causado su comentario a sido la motivación para irme a dormir. un saludo y gracias.

Un argumento aplastante, irrebatible.

Me alegro de contribuir a su descanso.

Un saludo.

A mí, su «a sido» me causa inquietud.

No controlo demasiado bien el teclado del móvil y seguramente me pase mas veces. No obstante sigue usted sin argumentar nada. No es raro, les pasa a muchos. Es la cultura del «zasca», muy popular entre los que no tienen nada que decir.

Un saludo.

Pingback: Se necesita un cuerpo para entender el mundo: ¿Por qué ChatGPT y otras IA lingüísticas no saben lo que dicen? – Esfera Comunicacional

Pingback: Inteligencia artificial: prohibiciones arriesgadas - joselazaro.eu