En junio de 2014 infinidad de medios de comunicación nacionales y sobre todo internacionales abrían, no solo su sección tecnológica, sino incluso algunas de sus portadas con una noticia que invitaba a la indignación: Facebook había llevado a cabo un «experimento secreto para manipular las emociones de casi setecientos mil usuarios».

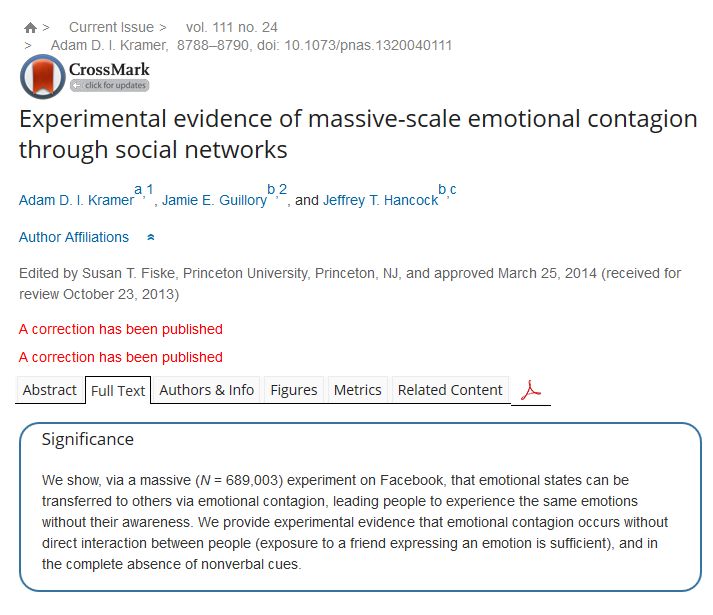

La noticia surgía tan solo unos días después de la publicación en Proceedings of the National Academy of Sciences (PNAS) de un estudio realizado por los investigadores Adam Kramer, Jamie Guillory y Jeffrey T. Hancock titulado Evidencias experimentales de contagio emocional a través de redes sociales.

El llamativo título del estudio y, sobre todo, el hecho de que se hubieran utilizado las publicaciones de usuarios de Facebook sin haberles avisado con anterioridad, hizo que una especie de locura hipocondríaca se apoderara de numerosos medios acusando a los responsables de la célebre red social de «manipular las emociones de los usuarios».

Como podréis comprobar en las portadas de la imagen superior, y a poco que busquéis por internet, la información ofrecida sobre el estudio en multitud de periódicos, radios y televisiones fue bastante exagerada y poco acorde con lo que realmente sucedió. Hubo incluso telediarios que abrieron sus ediciones con frases como «Facebook nos utiliza como ratas de laboratorio» o «Facebook juega con las emociones de los usuarios».

Lo cierto es que el paper publicado en PNAS es bastante inocuo —yo diría incluso que bastante evidente— pero sobre todo está muy alejado de los titulares sensacionalistas que vivimos en la prensa.

Realmente todo lo que hicieron los investigadores fue analizar las publicaciones de un gran número de usuarios de Facebook (N=689.003) y llegar a la conclusión de que las emociones que mostraban en sus actualizaciones eran muy proclives de propagarse a otros usuarios. De esta manera, si en Facebook ves una publicación triste de alguno de tus amigos es muy probable que tu próxima actualización esté acorde a esa emoción, o si lees un artículo alegre que algún amigo ha compartido, es muy probable que tu próximo mensaje en Facebook sea también alegre.

Por supuesto fue un error, un grave error, no haber comunicado a los usuarios que sus publicaciones estaban siendo objeto de un estudio sociológico.

Sí, pero también es cierto que después de conocer en qué consistía realmente el paper publicado no hay signo de manipulación alguna a nadie. Es más, las actualizaciones son públicas y cualquiera puede hacer un estudio, encuesta o análisis de lo que se comparte en Facebook, Twitter o cualquier otra red social abierta.

Deberían haber pedido permiso, repito. Sí, claro. Pero de ahí a manipular emociones, ratas de laboratorio o jugar con los sentimientos de los usuarios hay un abismo.

No obstante, Facebook pidió perdón públicamente —unas disculpas bastante light, cierto, pero acordes con el venial pecado que habían cometido— y en el artículo científico de PNAS se incluyeron dos actualizaciones —marcadas en rojo en la imagen superior— en las que se manifestaba un «Editorial expression of concern» y posteriormente una corrección. Demasiado pescado para tan poca caña.

He querido empezar por atrás —todo lo relatado hasta ahora representa solamente el final de la historia— porque lo realmente fascinante de este tema no es lo que conocimos en la prensa. El cómo se llegó a este estudio, los prolegómenos y la cadena de sorpresas que llevaron a realizarlo es otra historia mucho más increíble y apasionante.

Es la historia, desconocida pero fascinante, del experimento de Facebook sobre las emociones. La han desvelado hace pocas semanas, Jad Abumrad y Robert Krulwich en el fabuloso podcast Radiolab que se emite en la National Public Radio de Estados Unidos.

Y nuestro relato comienza aquí: 26 de diciembre de 2011.

La Navidad es un lío para Facebook. En esas fechas las felicitaciones, eventos, y las notificaciones de los usuarios escribiendo a sus familiares vuelan elevando el tráfico de la red hasta las nubes. Actualmente hay aproximadamente 1390 millones de personas con perfil en Facebook, esto lo convertiría —virtualmente— en el país más poblado de la Tierra, superando a China que tiene 1357 millones. De hecho, en la actualidad, hay más usuarios de Facebook que católicos.

Las cifras en esta historia son fundamentales. El fenómeno social que representa Facebook no tiene precedentes en ninguna época de la humanidad. Lo diré en letra: mil cuatrocientos millones de usuarios activos. Ni siquiera contamos todos los perfiles borrados.

La actividad diaria que puede llegar a generar un número de ese calibre es espeluznante. Cualquier pequeño problema que surja en esa página, aunque tan solo afecte a un ínfimo porcentaje de usuarios, es un problema de cientos de miles de afectados.

Pensad solamente en las fotos. Aquí va una cifra: en 2011, año en el que se inicia nuestro relato, se subieron a Facebook setenta mil millones de fotos. No os perdáis en los números, intentad empaparos de ellos para comprender el conjunto completo. Un siete seguido de diez ceros… foto, foto, foto, foto. Miles de fotos por segundo subidas por usuarios en todo el mundo. Solamente en aquella semana de Navidad de 2011, desde el 24 de diciembre hasta el 1 de enero, se subieron a Facebook más fotos que en toda la historia de Flickr.

Eso ya lo sabían los informáticos de Facebook cuando se fueron de vacaciones navideñas. Lo que no sabían era lo que se iban a encontrar al regresar a las oficinas el día 26 de diciembre: millones y millones de denuncias sobre esas fotos. ¿Qué había ocurrido?

Facebook tiene una política muy estricta con sus contenidos. No permite imágenes de desnudez, de consumo de drogas, fotos de actividades ilegales… Sin embargo aquella cantidad de photo’s report era simplemente desmesurada.

Los responsables se reunieron y antes de hacer nada al respecto, antes de escribir al usuario o retirar ninguna de esas fotos denunciadas, decidieron echarles un buen vistazo. Primera sorpresa: el 97% de todas esas fotos eran imágenes corrientes y molientes. En la inmensa mayoría no solo no había nada ilegal, es que ni siquiera eran fotos de mal gusto… muchas eran de familias celebrando las entrañables fechas en las que estaban, fotos de mascotas o de parejas sonrientes.

El ingeniero informático de Facebook Arturo Bejar explica que no sabían qué hacer ante aquel aluvión de foto-denuncias. ¿Revisarlas todas? Imposible. Examinar una por una y decidir si retiraban tal cantidad de fotos hubiera necesitado de un ejército de trabajadores durante meses y meses. Imaginad una nave industrial entera, llenadla con diez mil mesas, diez mil sillas, diez mil ordenadores y diez mil personas revisando individualmente cada foto antes de decidir si había que borrarla o no… No, aquello necesitaba una solución más específica.

Facebook decidió probar algo diferente para ahondar en el problema. ¿Por qué quería la gente retirar esas fotos? Bueno, vamos a preguntarles a unos cuantos usuarios a ver qué dicen. Segunda sorpresa: la gran mayoría de los que habían denunciado esas fotos, ¡estaban en la foto!

Esto no era una cuestión de fotos ilegales, de desnudez, de imágenes violentas… Era una cuestión personal de los usuarios. Muchas eran de parejas que habían roto, usuarios que no querían aparecer en esa fiesta junto a su cuñado con el que se llevaban fatal, mascotas que habían fallecido y les hacían sentirse tristes, o simplemente les daba vergüenza aquel momento y aquella foto. No era un problema de denuncia, allí en aquellas imágenes había sentimientos, dramas humanos, relaciones y emociones.

En aquel momento para denunciar una foto en Facebook hacías clic en la opción de photo report y la enviabas. No había nada más, no existía ningún mecanismo que incluyera el motivo por el que querías eliminar esa foto de la red social exceptuando los motivos legales de violencia, ilegalidad, etc. Los usuarios denunciaban fotografías pero no podían decir por qué querían que fuesen retiradas.

Se organizó una nueva reunión para decidir qué hacer a continuación. La decisión ya no era si retiraban unas cuantas fotos o no, esto era algo más profundo y la gran pregunta que rondaba las cabezas de los responsables de Facebook ahora era qué pensaban los usuarios sobre sus propias fotos. Así que hicieron lo más lógico, preguntarles.

Se eligieron unos cuantos miles de usuarios que habían denunciado fotos y se les preguntó lo siguiente: «¿Qué sientes cuando ves esta foto?».

A continuación incluyeron varios epígrafes para que el usuario pudiera elegir: 1. Embarrasing (vergüenza, embarazoso), 2. Anger (enfado), 3. Sadness (tristeza), etc. Eligieron algunas emociones y al final añadieron una opción extra que ponía «otras» en donde el usuario podía escribir lo que quisiera.

Los resultados de esta pregunta fueron muy confusos, al menos en un principio.

Aproximadamente un 50% de los que contestaron eligieron alguna de las opciones predeterminadas, mientras que el otro 50% utilizaron la opción Others. Lo extraño es que la mayoría de que aquellos que eligieron Others escribieron como respuesta: «It’s embarrasing». Una respuesta que paradójicamente ya estaba en las opciones anteriores. ¿Qué ocurre aquí? ¿Por qué tanta gente escribía en la opción Others y elegían una respuesta que ya existía en las opciones que Facebook le daba al principio?

Después de darle muchas vueltas al asunto se fijaron en que los usuarios que habían contestado «It’s embarrasing» estaban modificando su pregunta para ser más específicos. Cuando les preguntaban: ¿Cómo te sientes cuando ves esta foto? La opción 1. Embarrasing significaba que el usuario se sentía avergonzado… Pero no era eso lo que los usuarios querían expresar, no eran ellos los que estaban avergonzados. ¡Era la foto! IT’S embarrasing… la foto es embarazosa, la foto es vergonzosa. Aunque soy yo el que aparece en la foto, no soy yo… es la foto.

Cada paso que daban les hacía comprender que estaban ante una cuestión psicológica. La relación entre emociones personales y tecnología debía ser tratada por alguien más aparte de un puñado de ingenieros informáticos. Necesitaban expertos en psicología para poder llegar al fondo del asunto.

Lo siguiente que decidieron hacer fue deshacerse de las opciones y empezar desde cero.

¿Queremos que el usuario nos explique cuál es el problema con esa foto? Bien, pues dejemos que lo explique él mismo. No demos opciones predeterminadas, pongamos simplemente una caja en blanco de diálogo entre el usuario molesto por la foto y el usuario que la subió. Solo eso, simple y directo: se abre un pop-up entre dos usuarios y que ellos hablen para solucionar el problema.

¿Resultado? Desastroso… Menos del 20% de los usuarios a los que pusieron en contacto para solucionar el problema de la foto utilizaron realmente esa caja de diálogo en blanco. Parece que poner opciones predeterminadas funcionaba mejor que dejar a los usuarios que arreglasen por ellos mismos la cuestión de si retirar o no la foto.

Pero resulta que esa ausencia de diálogo significaba algo, y estaba bastante claro: los usuarios no quieren tratar problemas embarazosos con otros usuarios. Los ingenieros comprendieron que podría resultar algo violento que un usuario tuviera que arreglar ese problema con otro usuario que, en el caso de estas fotos, posiblemente era tu exnovia o alguien con quien no quieres hablar. Claramente los usuarios estaban diciendo: «Es tu problema Facebook, arréglalo tú, yo no voy a hablar con ese otro usuario para que quite la foto».

En Facebook volvieron las reuniones y surgió otra idea: ¿Y si los ponemos en contacto con una opción ya predeterminada por nosotros? Sigamos con la caja de diálogo pero ahora en lugar de dejarla en blanco, vamos a poner nosotros el mensaje. De esta manera a los usuarios que habían reportado una foto que querían que fuese borrada se les abría una caja de diálogo con la siguiente frase: «Ey, me gustaría que quitases esa foto».

Era una frase sencilla, directa —algunos consideraron que era incluso demasiado directa— que podría solucionar el asunto de las fotos. Y no se equivocaban: resultó que el porcentaje de usuarios se incrementó notablemente hasta casi un 60%, una mejoría impresionante respecto al pobre 20% que quisieron usar la caja en blanco.

Estaban ante una de las primeras conclusiones en firme: en este tema tan delicado los usuarios prefieren las opciones dadas por un tercero —en este caso Facebook— antes que entablar un diálogo directo con la persona que subió la foto.

Ante este primer éxito decidieron probar con otras frases para comprobar cuál era la más adecuada para el usuario. Y así se incluyeron otras versiones como «¿Te importaría quitar esa foto?», «Perdona que te moleste, ¿podrías quitar esa foto?», «Por favor, ¿podrías quitar esa foto?», etc. Los datos, respuestas y porcentajes comenzaron a aparecer y el equipo de Facebook analizó también la tasa de éxito de cada una de estas opciones de pregunta comparándolas con el porcentaje de fotos que el otro usuario había accedido a retirar.

Los ingenieros de Facebook se encontraron delante de sus narices y sin haberlo buscado en un primer momento muchas respuestas a cuestiones fascinantes de psicología, de emociones y de la relación del usuario frente a una tecnología que incluye interacciones sociales con otros usuarios.

Llamaron a un puñado de especialistas en diversas ramas —psicología, neurociencia, comportamiento social— para que les ayudaran a tratar con aquel torrente de información y finalmente llegaron a algunas conclusiones.

Por ejemplo: Poner el nombre del usuario al que pides algo ayuda a que lo consigas. Así, la frase «Ey, ¿te importaría quitar esa foto?» funciona peor que si se incluye su nombre: «Ey, Javier, ¿te importaría quitar esa foto?». Descubrieron que utilizar «¿Te importaría quitar esa foto?» (Would you mind take down this photo?) funciona mejor que «¿Podrías quitar esa foto?» (Could you take down this photo?).

Se encontraron incluso que pedir perdón antes de pedir algo no funciona: las frases que incluían términos como «Perdona» o «Disculpa que te moleste» conseguían que menos usuarios retiraran las fotos.

Actualmente, y después de muchos quebraderos de cabeza, la caja que aparece en Facebook cuando quieres quitar una foto tiene el siguiente aspecto e incluye las cuatro razones más utilizadas por los usuarios:

Esta historia de fotos, denuncias y respuestas de usuarios hizo que los responsables de Facebook comprendieran la necesidad de incluir entre su plantilla a especialistas en conducta humana y psicología. Diariamente tienen que lidiar con cientos de millones de relaciones entre personas, emociones y sentimientos encontrados, un campo en el que los informáticos y analistas de datos con los que contaban se veían desbordados.

Y es ahora donde vuelvo a recordar la dimensión del fenómeno Facebook y sus números. Mil cuatrocientos millones de personas metidas en un mismo lugar, relacionándose y comunicándose a un nivel jamás visto en la historia del ser humano. Un campo increíble con posibilidades ilimitadas para estudiar la conducta humana y para realizar estudios científicos que nos ofrezcan respuestas a infinidad de cuestiones sociológicas, políticas, psicológicas…

Es un terreno fascinante para investigar, aprender y conocer y personalmente no me gustaría renunciar a él; aunque eso sí, estimados responsables de Facebook, lo mejor es que en un futuro primero pidan permiso a sus usuarios.

Pingback: La otra historia, desconocida y fascinante, del experimento de Facebook sobre emociones

Pingback: La otra historia del experimento de Facebook sobre emociones | colaboraciones con otros medios | La Aldea Irreductible

Qué problema gordo este de las fotitos eh….

La humanidad es gilipollas

Amén.

Pingback: La otra historia, desconocida y fascinante, del experimento de Facebook sobre emociones | Texto casi Diario

Hombre… pensar que tuvieron que pasar 4 años y alcanzar los 1000 millones de usuarios para darse cuenta de que necesitaban un psicólogo en el equipo es un poco ingenuo.

Tanto como imaginar facebook como un puñado de ingenieros en plan «vamos a poner este botón aquí a ver qué pasa».

Sorprende este pronto benévolo y naif que le ha entrado a jotdown con facebook últimamente…

Así que la prensa no es de fiar, hicieron del gato un tigre…que malo es internet!

Y lo de que la humanidad es bastante gilipollas (con fb o sin el)… no sabía que estaba en discusión!

El autor de este artículo no ha debido entender en qué consistió el estudio que Fb hizo sin consultar a sus usuarios. Haga el favor de leerlo, usted mismo ha colgado el enlace y verá que hay un grupo de control y uno manipulado. ¡Lo que hizo Fb no era analizar las respuestas de los usuarios! Lo que hacían era modificar su algoritmo habitual para que un grupo de individuos recibiese más contenidos negativos o positivos que el grupo de control. Cualquiera entiende que hay una diferencia abismal entre un estudio de observación y otro en el que se manipulan variables para ver qué ocurre.

Que una plataforma que tiene «más usuarios que católicos existen en el mundo» juegue a comprobar si posee suficiente poder como para manipular sus estados de ánimo merece como mínimo portadas, titulares, críticas… y un abandono masivo de sus usuarios.

Me parece muy bien que a JotDown le guste Fb, pero quitarle miga al asunto sabiendo lo que sabemos después de Snowden no habla muy bien del medio.

Pingback: Enlaces de ayer y hoy (edición nº 36) - Iván Lasso