Viene de aquí.

Decíamos ayer que la pregunta central del libro que vengo comentando es si existen fenómenos «entencionales» en la definición que se daba en el artículo anterior o si, por el contrario, estos fenómenos no son sino una manera de describir algo demasiado complejo que solo aparenta tener un fin. En resumen, si la vida y la conciencia implican la posibilidad de una actuación finalista o si esto es un espejismo.

La vida —y, por tanto, la mente— parece contrariar la tendencia termodinámica. Las leyes de la termodinámica exigen que la entropía aumente hasta alcanzar su valor máximo. Cuando hay diferentes estados posibles, lo más probable es que la suma de estados «desordenados» se imponga precisamente porque son más probables. Así, llegados a cierto punto, por mucho que los componentes individuales cambien, el efecto macroscópico será similar. Las partículas de un gas, sin influencia externa, no se arracimarán todas en una esquina del recipiente, porque eso es muy improbable comparado con la presencia de un número más o menos similar de partículas en cada lugar de ese mismo recipiente. La mezcla es más probable, la separación más improbable.

La vida —que sí exige una acumulación de discontinuidades del mismo signo— es problemática considerando esas leyes inexorables. En consecuencia, ¿por qué hay vida? Una salida de esta trampa fue enunciada por Schrödinger cuando escribió su famoso ¿Qué es la vida?: los procesos vitales solo aparentemente no cumplen con el segundo principio de la termodinámica. En realidad, funcionan como mecanismos disipativos. Es decir, ante la existencia de un gradiente provocado por la energía solar —que permite realizar un trabajo—, la vida funciona como un magnífico sumidero, capaz de acelerar el proceso de disipación de esa energía en el sistema del que forma parte nuestro planeta. La vida no solo se ajusta a la termodinámica, sino que es inexplicable sin ella.

Para muchos, a esto solo hace falta añadir el impulso que se produce por la selección natural. Si la complejidad de la vida es resultado del cambio azaroso luego retenido, no es necesario incluir ninguna finalidad en la ecuación. Esta idea, además, podría extenderse a otros campos (y así ha ocurrido), mediante la llamada ley del efecto. Un ejemplo ilustrativo sería el de nuestro sistema inmunitario. La lógica nos dice que la respuesta inmune se produce mediante algún tipo de mecanismo que seguiría este orden: primero aparece el agente infeccioso; su presencia da lugar a la síntesis de moléculas que pretenden desactivarlo; si se halla la respuesta, el cuerpo la produce de forma masiva. La realidad es justamente la contraria. Mediante el proceso conocido como hipermutación, que tiene lugar antes del nacimiento, se produce un catálogo ingente de potenciales anticuerpos. La mayoría nunca servirán para nada. Sin embargo, algunos de ellos serán formas especulares (y no es preciso que lo sean a la perfección) de alguna molécula del agente invasor. Una vez comprobada la eficacia de alguno de esos anticuerpos, es cuando el organismo los produce en gran número.

Este mecanismo ciego llevó a ilustres científicos, como Ernst Mayr, a postular que se podía evitar la teleología incluyendo los procesos vitales dentro de lo que llamó teleonomía: la asimetría que parece finalidad sería resultado de un programa, tal y como sucede en un termostato. Esto, además, encaja con la naturaleza discreta de la información genética: el código se encontraría en los genes que codifican las proteínas que construyen las máquinas celulares que conforman el organismo que es capaz de reproducir seres que incorporan el código. Parecía que lo de menos era el andamiaje y que lo importante era la información, por lo que no es de extrañar que Richard Dawkins diera el paso de centrar la selección natural en los propios genes en su conocidísimo El gen egoísta. Pronto muchos autores señalaron el aspecto más problemático de esta tesis: dejar fuera de foco al organismo, concibiéndolo como un simple vehículo para la selección natural. O por decirlo de otra forma, convertir a los elementos pasivos de la selección natural, el entorno y el ADN, en los protagonistas, obviando la necesidad de que exista una forma de organización unitaria y dinámica que permita traducir esas instrucciones, copiarlas y producir copias iguales a sí misma, manteniéndose el tiempo suficiente contra las leyes naturales que impulsan a toda la materia hacia la mezcla. Además, centrarse en el molde informacional es una manera de soslayar la realidad de que no existen partes en los sistemas vivos susceptibles de diferenciación sin merma: desde situaciones previas menos complejas, los organismos evolucionan en el tiempo diferenciándose internamente mediante discontinuidades y mediante modularización de funciones. La dificultad de explicar esa unidad dinámica temporal se pretende evitar convirtiendo a la vida en un manual de instrucciones. El problema de pensar así es el siguiente: si la complejidad de la vida resulta de la variación y preservación de la información genética, y la información genética requiere un sistema que traduzca, utilice, copie y reproduzca esa información mediante la hazaña de construir una réplica de sí mismo, ese sistema se configura como una condición sine qua non de la selección natural, que no pudo, precisamente por ser su prerrequisito, surgir por esa misma selección natural. Y ese sistema dinámico presenta unas características que lo hacen extremadamente improbable y que no se explican por la aplicación de la ley del efecto. Deacon propone no eludir el problema de la finalidad, sino explicar cómo surgió de donde no existía antes. No excluir la causalidad final, sino darle carta de naturaleza científica. Si los fenómenos entencionales y con ellos una nueva forma de causalidad nacen en un momento dado, pese a que la materia sigue siendo necesariamente la misma, la clave ha de estar en su organización. Una forma de organizarse de la materia que ha tenido que emerger de lo que existe, pero que ha de ser sustancialmente diferente. Un total que no coincidiría con la suma de sus partes.

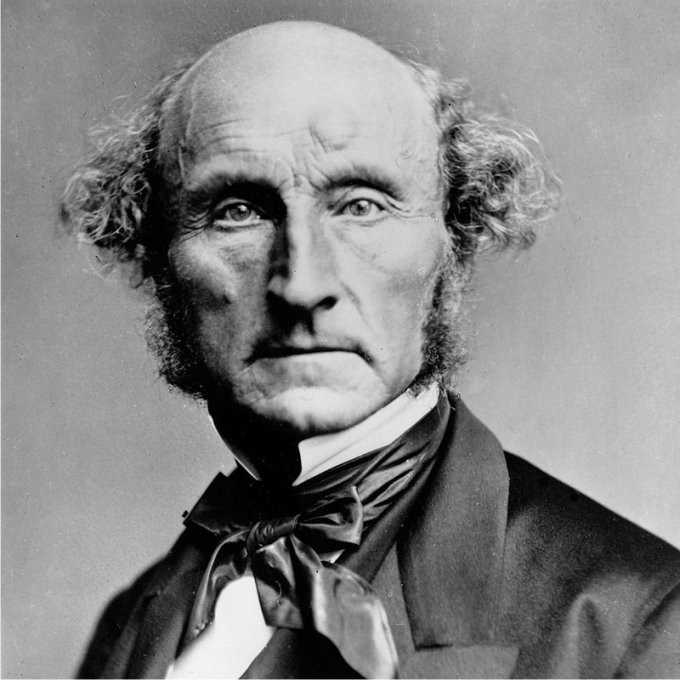

El concepto de emergencia, de transición emergente, no es nuevo. En el siglo XIX fue materia de discusión filosófica y, en particular, se convirtió en uno de los animales favoritos de John Stuart Mill. Sin embargo, los éxitos científicos derivados de la parcelación de los problemas y el extraordinario aumento de conocimientos en bioquímica fueron convirtiendo sus elucubraciones en residuales. En cualquier caso, la idea de que las propiedades de una organización emergida no fueran predictibles pese a conocer todos sus componentes, hasta el punto de que de ellas surgieran leyes propias, distintivas, estuvo presente en las reflexiones de filósofos y científicos de todo tipo. Por poner un ejemplo, el neurólogo Roger Sperry defendía que las propiedades del sistema completo de moléculas que interactúan en un cerebro son básicamente diferentes de cualesquiera otras que pudieran exhibir esas moléculas organizadas de otra forma. Por tanto, la pertenencia de esas moléculas a una totalidad provocaba la aparición de respuestas que no existirían sin esa configuración y que, en ese sentido, son nuevas. El sistema dinámico crearía una causación descendente que afecta a sus partes, nacida de su forma, como sucede con las partículas de una rueda, que aunque puedan ser idénticas a cualesquiera otras, exhiben una capacidad colectiva de desplazamiento que es producto de una configuración macroscópica. La partícula no rueda porque se la induzca a cambiar de alguna forma, sino porque se han restringido sus caminos posibles, alterando decisivamente sus probabilidades de cambio. A esto se uniría que la aparición emergente modifica incluso las partes, que se fusionan, de forma que el camino inverso ya no pueda recorrerse (en forma similar a lo que sucede en el colapso cuántico). En estas reflexiones empieza a aparecer un elemento toral: el de ligadura. Luego volveremos a él, pero antes es importante hacer referencia a la crítica más devastadora del concepto tradicional de emergencia: la que formuló el filósofo norteamericano Jaegwon Kim y que tiene que ver con la llamada doble contabilidad causal. Si atribuimos la potencia causal de cualquier forma de organización, por compleja que sea, a las interacciones físicas básicas de sus componentes, afirmar que, por el hecho de organizarse de una determinada manera, esto provoca la aparición de nuevas formas de causación es invariablemente redundante. Toda forma emergente tendría, por tanto, que ser resultado de las propiedades de sus componentes.

El único camino para evitar esta crítica es precisamente el más fructífero y atractivo. La crítica se basa en la existencia de algo parecido a los ladrillos no reducibles de la materia. Solo así puede hablarse de contabilidad causal como suma de interacciones. Sin embargo, a partir de un cierto nivel, la realidad se convierte en un mundo fantasmagórico, en el que no hay ladrillos, sino campos sin propiedades discretas sino probables, que se definen también de forma dinámica, y que impiden que la discusión parte/todo tenga una respuesta unívoca. Si no hay un ladrillo último no organizado, sino que la realidad irreductible es también una forma de organización, nada impide que un cambio organizativo a un nivel superior pueda ser una fuente de potencia causal diferente.

Más aún, la emergencia se transforma, dejando de lado el aspecto estático parte/todo y su análisis estructural, y «emergen» fenómenos en los que la clave es dinámica, en la que lo que importa es el proceso. Esta vía se reforzó como consecuencia del estudio de los fenómenos de «autoorganización», de los que hablaré más adelante, y de las simulaciones resultado de operaciones iteradas mediante la aplicación repetida de algoritmos que, partiendo de sucesos aleatorios, engendraban regularidades que fueron pronto llamados atractores, y que tan populares se hicieron a través de las teorías del caos y de la complejidad. Estas ideas encajan sensiblemente con lo que sabemos de los organismos vivos: existen en cuanto que procesos, porque en el momento en que dejan de cambiar la vida se extingue. Y esto, naturalmente, complica muchísimo cualquier análisis, ya que los análisis estáticas son más abordables. Esta objeción es particularmente aplicable a los fenómenos más complejos, como la conciencia: de ahí que resulten tan torpes las aproximaciones actuales a la vida cerebral, basadas en el metabolismo medio de células situadas en regiones específicas, en lapsos de tiempo que, considerando la extrema velocidad de los procesos mentales, equivalen a pretender comprender la quinta sinfonía de Beethoven, escuchando unos pocos compases salteados, escogidos porque en ellos intervienen muchos instrumentos.

Lo importante, no obstante, sería probar que la emergencia de sistemas dinámicos puede ser fuente de formas de causalidad nuevas, a la vez que explicamos en qué consisten sus transiciones, para así poder concluir plausiblemente que existen cambios cualitativos y no nos estamos dejando engañar nuevamente por simples epifenómenos.

Antes mencioné que la clave de los sistemas dinámicos y de la transición entre ellos es la ligadura. Es un concepto muy potente, porque en gran medida disuelve discusiones sobre si lo que nos parecen fenómenos o tipos generales tienen alguna forma de realidad o son simples descripciones útiles. Su potencia deriva de su naturaleza negativa. Cuando se restringe la posibilidad de que los estados de un sistema tengan lugar, el resultado es que habrá menos formas en que difiera lo que sucede. Por tanto, un tipo general puede basarse no en cualidades positivas, sino simplemente en el hecho de que se excluyan ciertos estados posibles. La clase así descrita incluiría a categorías de objetos o fenómenos de los que no tendríamos que saber ninguna de sus cualidades. Su descripción sería del tipo: todos aquellos que no son esto o aquello.

Las ventajas son inmediatas. La organización nace desde la restricción, no de cualidades intrínsecas al sistema. Volviendo a los asuntos que nos ocupan en estos artículos, ya no hay propiedades abstractas y sin realidad material que tengan una potencia física inexplicable y pese a ello, es posible que haya una potencia causal diferente de la que resulta de la suma de las propiedades materiales de las colecciones de entes que forman parte del proceso. La explicación es que la ligadura, entendida como reducción de libertad, provoca un cambio geométrico. Una ligadura simplifica, pero lo único que sabemos es lo que no sucede. Ni siquiera tenemos que explicar que lo que está más constreñido está más organizado u ordenado. Solo sabemos que será más redundante, ya que son menos los caminos posibles. Más aún, lo que no está presente no puede interaccionar y el constreñimiento facilita que puedan repetirse fluctuaciones que tengan un reflejo macroscópico, y se desechen aquellas menos probables, con un resultado global capaz de efectuar un trabajo. ¿Puede ser lo ausente causa de algo? Indiscutiblemente, si lo vemos en estos términos.

Si la emergencia se basa en la noción de ligadura, es decir en la desaparición de estados posibles, y si caben emergencias sobre emergencias, con propagación de ligaduras y aparición de otras nuevas (en particular si son resultado de procesos no lineales en los que las fluctuaciones de bajo nivel desaparecen, alisadas por la suma de los resultados estadísticos probables), es inútil que pretendamos explicar la potencia causal de lo que queda atendiendo a sus partes. Más aún, es inútil que pretendamos que las causas finales y los procesos entencionales han de ser epifenómenos porque todas las causas son producto de las interacciones físicas de lo real que existe desde al menos los primeros momentos del Universo. Lo real existe desde el comienzo. Su configuración geométrica, sin embargo, varia, creando, mediante una danza ascendente, nuevas formas de organización, cada vez más complejas, capaces, incluso, de hacer predicciones sobre lo que aún no ha existido.

El profesor Deacon distingue, en esos procesos dinámicos, tres niveles sustancialmente diferentes. En cada uno de ellos surgen sistemas, productos que tienen tendencias ortógradas, es decir, intrínsecas, al modo de la vieja causa formal: caminos que se exploran porque coinciden con los recorridos probables creados por la geometría del sistema que emerge. A diferencia del cambio ortógrado (el móvil que permanece moviéndose o el sistema que se dirige hacia su máxima entropía), el movimiento contrágrado equivale a lo que llamamos causa en la mecánica postnewtoniana, un cambio inducido por alguna perturbación exterior, como en el choque de dos bolas de billar o en la aceleración de un sólido como consecuencia de una fuerza. A la planta baja de su edificio emergente, Deacon lo llama nivel homeodinámico. Es el lugar en el que las ligaduras tienden, sin necesidad de ningún impulso externo, a situarse en su mínima expresión, como sucede por aplicación del segundo principio de la termodinámica. De ahí sus digresiones sobre la energía (explicada como diferencia y no como algo que tiene materialidad) y sobre su persistencia pese a que, en cada proceso, parte de ella no sea recuperable. Sin embargo, no puede dejar de visitar los sótanos de su edificio: el lugar en el que se produce el movimiento contrágrado de las partículas, causa del alisamiento estadístico que medimos cuando decimos que un sistema tiende hacia la máxima entropía, a la vez que el movimiento contrágrado de las partículas se basa en una tendencia ortógrada de los átomos a colocarse en su configuración más estable conforme a las leyes de la mecánica cuántica.

En cualquier caso, el principio es lo más importante: cuando sistemas homeodinámicos, con tendencias ortógradas diferentes, se enfrentan e influyen entre sí, cada uno de ellos es una influencia contrágrada para el otro. En determinadas circunstancias, un incremento de las ligaduras de esos sistemas dinámicos por influencia mutua, puede provocar una emergencia de un nivel dinámico superior. A este nivel, Deacon lo denomina morfodinámico, y se caracteriza por la generación de estados más ordenados que son capaces de aumentar la entropía de forma más eficiente, aunque esto pueda parecer paradójico. Muchos de estos sistemas son conocidos. Quizás el más famoso es el proceso que genera las llamadas células de Bénard, una estructura hexagonal que surge en una capa líquida (normalmente aceite) de poca profundidad y calentada desde debajo uniformemente. Lo extraordinario es que, obligado el sistema a disipar el calor producto de un gradiente, resulte que la manera más eficiente es que se cree una estructura regular, que es en sí una forma de eliminación de energía por cuanto implica un trabajo. A su vez, esa forma supone la creación de ligaduras, ya que la probabilidad de encontrar átomos en las «paredes» de las celdillas hexagonales se incrementa lo suficiente como para generarla. Por tanto, ciertos caminos se hacen más improbables. Ejemplos similares se encuentran en el crecimiento de cristales de hielo, en el láser o en un huracán. Se trata de fenómenos tan importantes que muchos investigadores se sitúan en la termodinámica de sistemas alejados del equilibrio precisamente como punto de partida para explicar la vida. Los seres vivos serían, por tanto, sistemas dinámicos nacidos de la tendencia a la maximización de los procesos disipativos. Si la naturaleza aborrece los gradientes, la vida sería la forma de acabar más rápida y eficientemente con lo que la hace posible: la energía disponible para efectuar un trabajo.

Sin embargo, Deacon cree que este nivel dinámico emergente no basta para explicar la vida. Esos sistemas autoorganizativos tienden a «congelarse» mientras persiste el gradiente, no a reconstruir una y otra vez sus ligaduras, creando nuevos organismos. Deacon encuentra una original metáfora para ilustrar sus ideas: un sistema morfodinámico es como un edificio más caliente que su entorno tiende a enfriar. Si abrimos una puerta, eliminando una ligadura, se enfriará más rápidamente. Mejor si se abre una puerta de un piso alto, ya que el calor asciende. Ese ascenso equivale al proceso que se produce en las células de Bénard a las que antes hice referencia. El sistema disipará más eficientemente el calor, creando una especie de brisa interior. Sin embargo, esa brisa puede llegar a cerrar esa puerta o esa ventana abierta, creando un obstáculo a la tendencia termodinámica, reteniendo el calor. Ese trabajo de cierre, de aumento de ligaduras, es análogo al que surge cuando tendencias ortógradas de sistemas morfodinámicos colisionan provocando la emergencia de un sistema superior, más ligado, en el que el gradiente se utilice para crear las condiciones que permitan el mantenimiento y reproducción del propio sistema. A ese sistema dinámico emergente Deacon lo llama teleodinámico.

Ese nombre nos sitúa ya dentro del ámbito de lo entencional. Para un sistema teleodinámico su perpetuación es elemento integrante de su definición. Una vez traspasada la frontera de lo teleodinámico, la selección natural y la ley del efecto pueden desarrollar toda su gigantesca capacidad generadora. Solo es preciso explicar cómo pudo surgir sin utilizar precisamente la propia selección natural, como se indicó previamente en este artículo. El autor, con la exclusiva finalidad de demostrar que ese paso es posible, plantea una hipótesis de autogénesis que cumpliría los requerimientos mínimos de esa transición emergente. Así, los sistemas morfodinámicos autocatalíticos (reacciones químicas en las que un catalizador produce otros catalizadores iguales, mientras hay material disponible y energía libre) podrían crear las bases de la multiplicación, lo que unido a otros procesos morfodinámicos de autoensamblaje que diesen lugar a «cápsulas», podría generar procesos que se repetirían en el tiempo. La tendencia de los procesos autocatalíticos a la destrucción se vería limitada mediante su congelación en espacios autocontenidos hasta que, su apertura en un entorno más favorable, diera lugar a nuevos procesos de autocatálisis. Las tendencias ortógradas propias de esos sistemas morfodinámicos, al ser contrapuestas, se fusionarían en una dinámica superior, naciendo seres que se caracterizarían por su tendencia a la reproducción, a la preservación y a la «búsqueda» o, mejor, al aprovechamiento de los entornos favorables a la reproducción. En el sistema teleodinámico más simple, la aparición de ligaduras en un nivel superior, permite entrever esos procesos entencionales que tan oscuros parecen desde una perspectiva mecanicista clásica: la función, el valor, la prospección del futuro, el cálculo de probabilidades, la finalidad, la información, el yo.

Hablaré de ello en el siguiente y último artículo de esta serie.

Para descansar despues de la lectura con algo relacionado con el propio artículo propongo esto:

http://pmneila.github.io/jsexp/grayscott/

(el preset de solitones)

A medida que iba leyendo el artículo he ido pasando por las siguientes mini reflexiones:

barroco (muy barroco),

¡coño esto es sistémica!,

es una broma, se está cachondeando del personal.

Y por último,

me recuerda a las paridas oscurantistas espesas y sobrevaloradas de Martin Heidegger.

«… ya que los análisis estáticas son más abordables.»

«…que se podía evitar la teleología…»

A ver no soy partidario, a priori, de una teleología en la naturaleza, pero la frase en cuestión me suena como «se podría evitar la verdad», es decir, como la actitud del que, antes de saber nada de una cosa, ya tiene muy claro lo que ha de negar.

Pingback: Tsevan Rabtan: Naturaleza incompleta (y IV) – Conciencia

Pingback: Magapsine Semanal (8-14/09/2014) - Dronte